ETH Zurich y EPFL están a punto de lanzar algo que cambia las reglas del juego: un modelo de lenguaje grande completamente abierto, entrenado en infraestructura pública suiza. No es solo otro LLM más. Es una declaración de principios sobre cómo debería desarrollarse la IA.

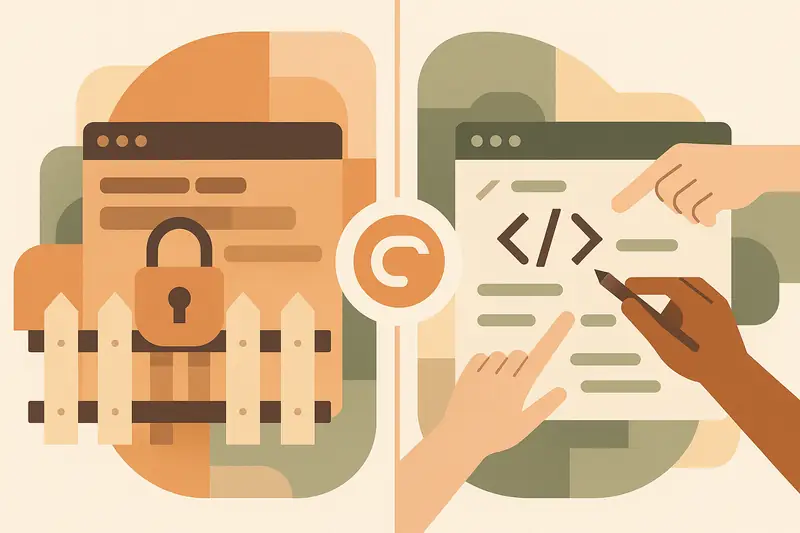

El modelo será "completamente abierto" - código fuente, pesos y datos de entrenamiento transparentes bajo licencia Apache 2.0. Esto contrasta radicalmente con los modelos comerciales desarrollados "a puerta cerrada" en Estados Unidos y China. La diferencia no es solo filosófica: es estratégica.

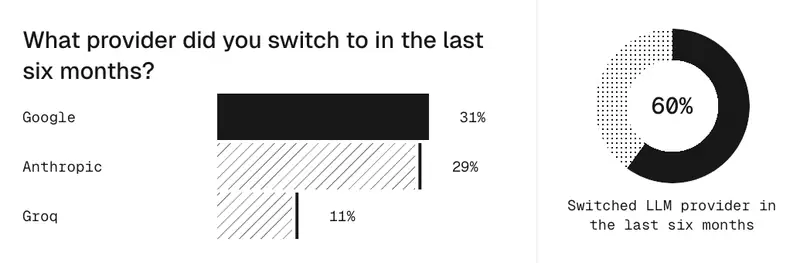

Lo más impresionante es su capacidad multilingüe: más de 1,000 idiomas entrenados en 15 billones de tokens de alta calidad. Un 60% en inglés, 40% en otros idiomas. Esto no es accidental - es diseño inclusivo a escala global. Mientras otros modelos priorizan el inglés, Suiza apuesta por la diversidad lingüística real.

El proyecto utiliza la supercomputadora "Alps" con más de 10,000 chips NVIDIA Grace Hopper y electricidad 100% neutra en carbono. Aquí está la lección: la soberanía tecnológica requiere infraestructura propia. Suiza no depende de recursos externos para entrenar sus modelos. Controla todo el pipeline.

Este modelo demuestra que los países pueden desarrollar IA avanzada sin sacrificar transparencia, inclusión o soberanía. Es una alternativa real al duopolio tecnológico actual. Para organizaciones que necesitan confianza, transparencia y cumplimiento regulatorio, este enfoque marca el camino a seguir.